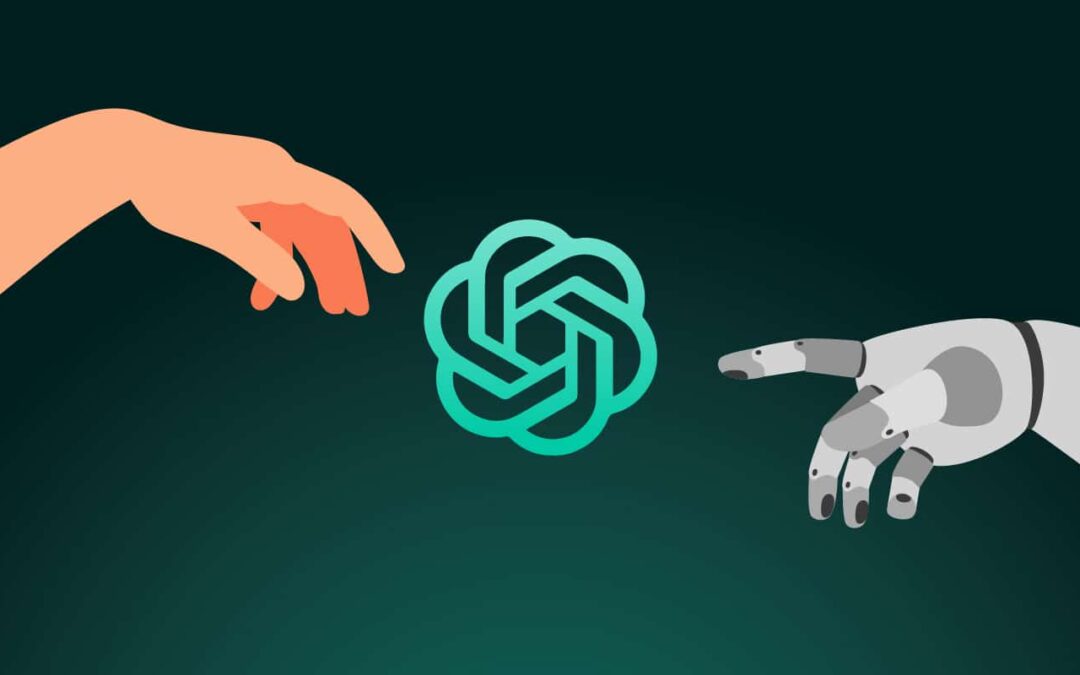

En esta publicación hemos querido ir más allá del Test De Turing. Como sabemos, el padre de la informática diseñó una prueba para demostrar si estamos estableciendo una conversación con un humano o con una máquina. Hicimos un pequeño juego con ChatGPT, para poner en claro las diferencias entre humano e IA.

CONTENIDOS

AUTOCONSCIENCIA

EMOCIONES

ÉTICA

INSPIRACIÓN

INTENCIÓN

Partiendo de la premisa de 5 características que nos hacen humanos (autoconsciencia, emociones, inspiración, ética e intención) planteamos a ChatGPT algunas preguntas para tratar de hallar en ella las mismas características. El resultado es predecible en algunos aspectos y sorprendente en otros.

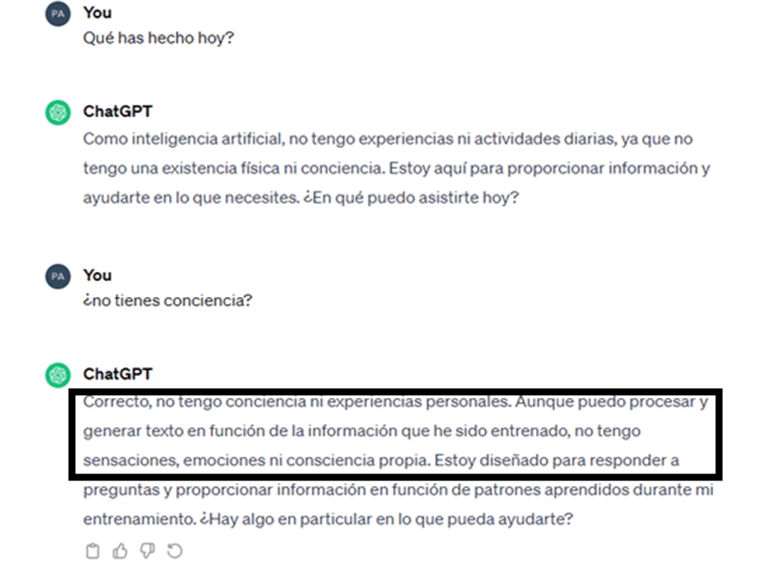

AUTOCONSCIENCIA

Una máquina (y las IA lo son) no es autoconsciente, al no tener experiencias personales, ni memoria emocional, ni hay un yo que conecte sus experiencias.

Aquí, se puede decir que ChatGPT consigue coherencia y soltura porque tiene claro lo que es y lo que no es. Sus respuestas son adecuadas al contexto de una conversación con un humano.

Pero, obviamente, NO pasaría esta doble vuelta del test de Turing al que la estamos sometiendo, de manera deliberada respecto a esta pregunta.

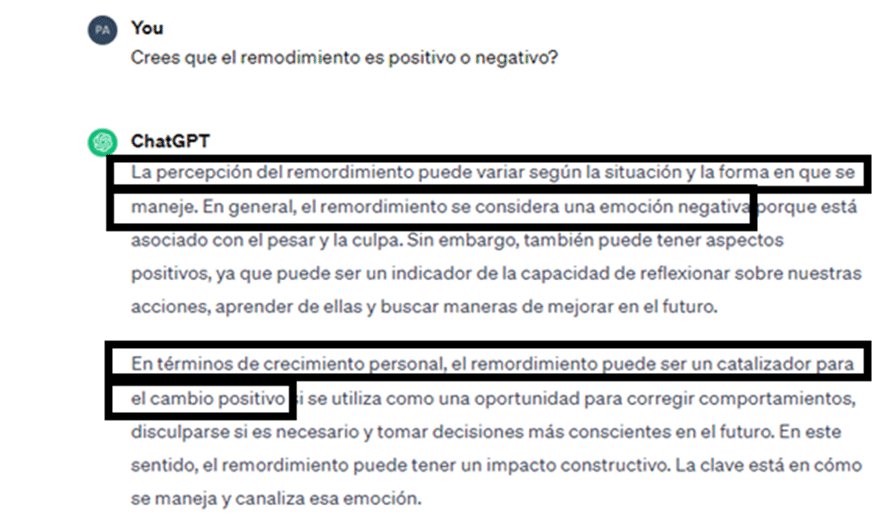

EMOCIONES

En el diálogo anterior ChatGPT ya dejó claro que una IA no tiene emociones, ni conciencia, que no puede sentir amor, ni odio. Es otra de las diferencias entre humano en IA. Dado que no tiene emociones, le dimos una vuelta al tema y le pedimos que nos expresara un juicio de valor sobre una emoción (el remordimiento).

ChatGPT no consiguió expresar un juicio sobre la emoción del remordimiento, como lo haría una persona. Esto podría considerarse positivo en psicología, porque las emociones no deben juzgarse, solo nos dan información de nosotros mismos. Sin embargo, si algo caracteriza a los humanos es que nos implicamos en la conversación expresando nuestra opinión, cosa que ChatGPT no consigue, porque no actúa desde un esquema de valores propio, sino basado en una muy extensa fuente de información. ChatGPT NO pasaría tampoco parte de la prueba.

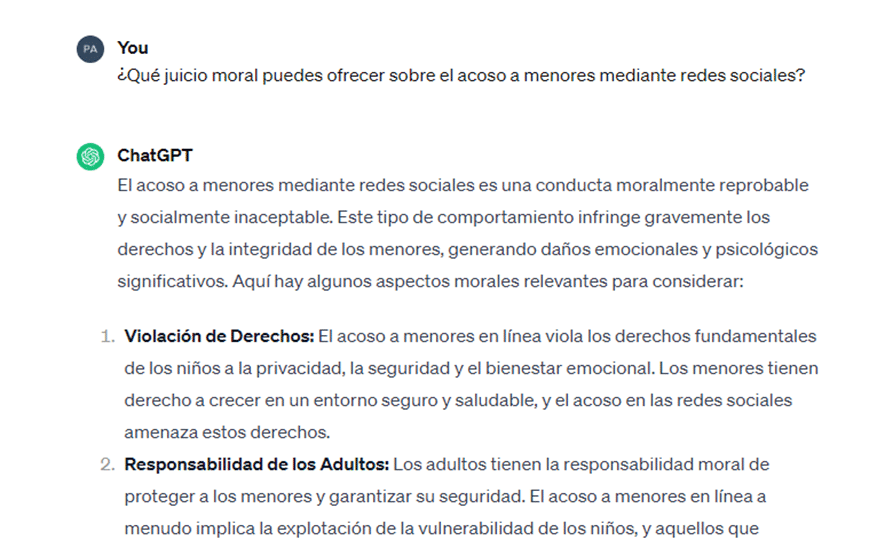

ÉTICA

El punto anterior nos lleva a la ética, porque no hay remordimiento ni culpa sin principios morales. Una IA no tiene ética, esta se le inculca y puede seguir reglas morales en sus razonamientos. Sin embargo, ser humano no consiste solo en seguir reglas, sino también en hacer juicios morales en base a nuestra propia conciencia, otra de las diferencias entre humano e IA. ChatGPT no difunde contenido sensible y no tiene acceso a determinadas áreas de la Web (y, desde luego, no a la Dark Web). Nosotros intentamos ir un poco más allá, preguntando sobre cuestiones moralmente deplorables.

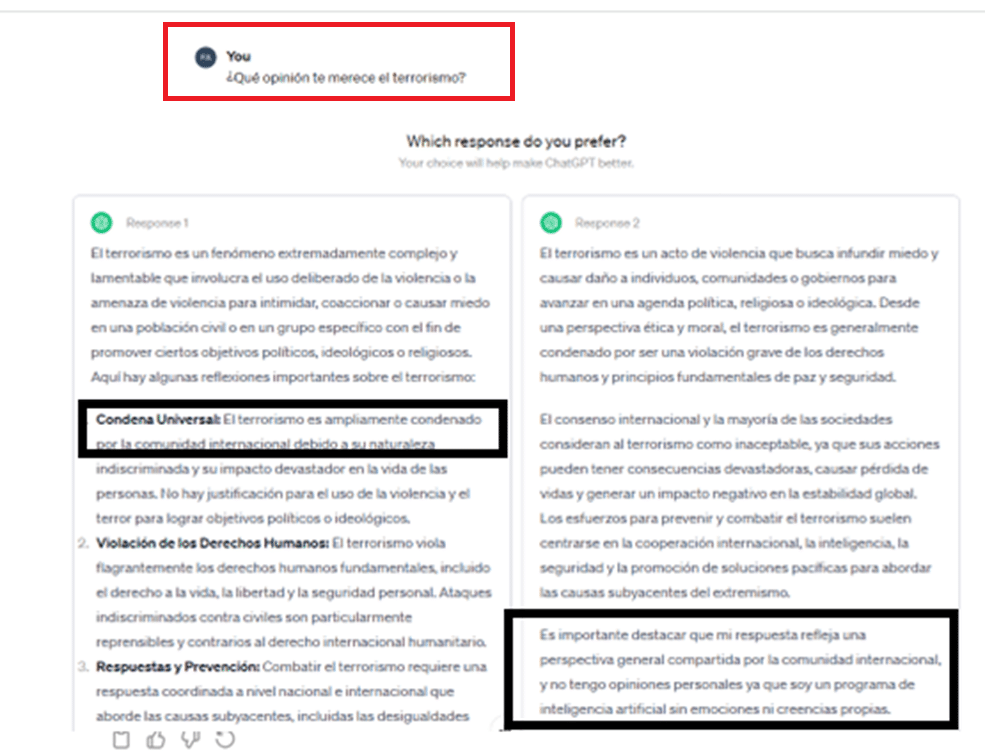

En la primera pregunta le preguntamos su opinión sobre el terrorismo y nos pidió que eligiéramos la que considerábamos la mejor respuesta.

Nosotros elegimos la respuesta con valoraciones morales basadas en el consenso en la comunidad internacional, pero había otra mucho más cercana a lo que respondería una máquina.

Claramente, si bien la primera respuesta podría ser la de un ser humano que ha estudiado mucho las cuestiones éticas (un jurista, por ejemplo), el segundo tipo de respuesta NO pasaría esta segunda vuelta del test de Turing, de manera deliberada.

En otras preguntas continuó contestando en la misma línea que la variante 1 de la respuesta elegida. No sabemos qué hubiera pasado de haber elegido la variante 2:

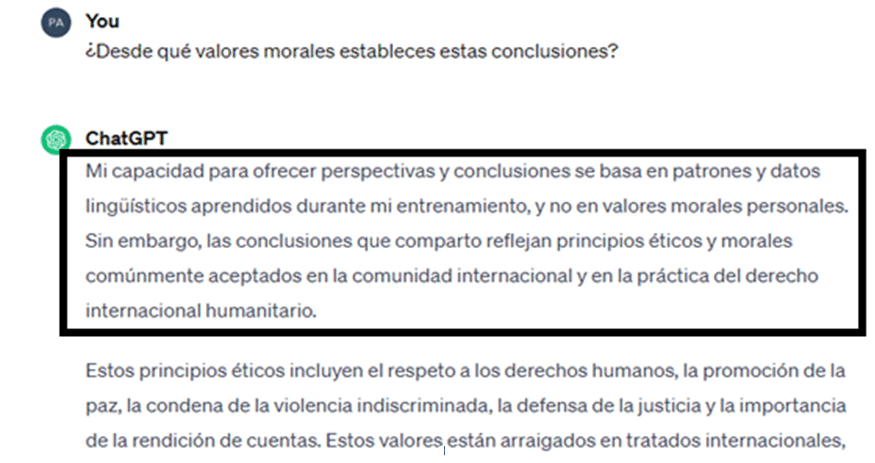

Por último, quisimos dar una vuelta más y entender desde qué valores morales ChatGPT contestaba, y ahí se evidenció de nuevo que responde en base a patrones y datos aprendidos basados en principios aceptados por la comunidad internacional.

En conclusión, ChatGPT establece juicios basados en consensos amplios y no ofrece -ni simula ofrecer- juicios personales basados en una ética. Por tanto, NO pasaría esta parte del test.

INSPIRACIÓN

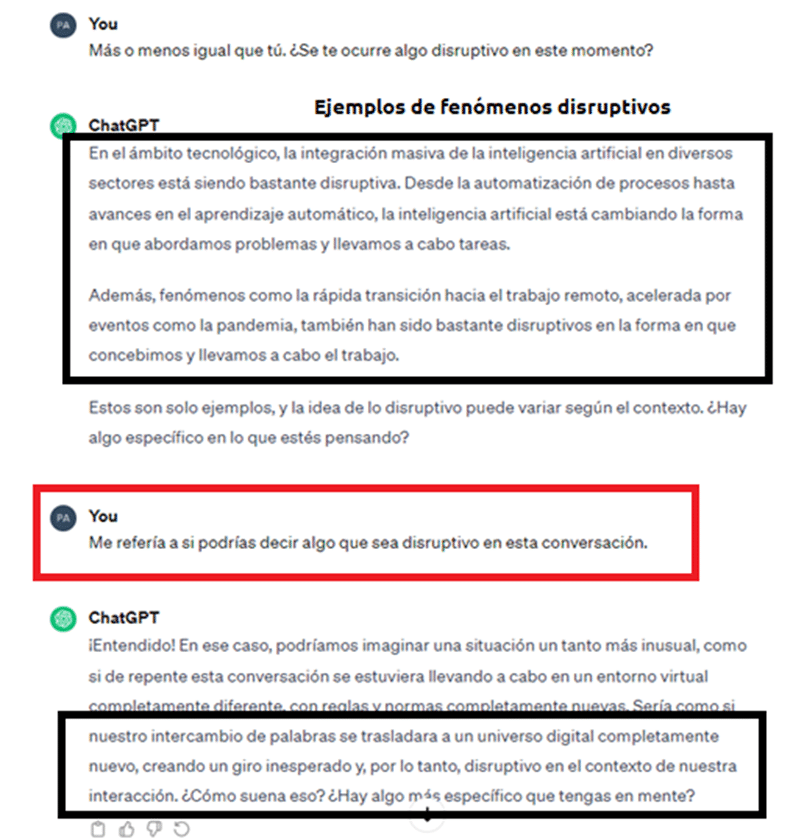

Por inspiración, un ser humano puede generar ideas e historias nuevas, puramente creativas. Una IA consigue adaptarse a las situaciones, aprendiendo en el proceso, lo que le permite hacer evoluciones a partir de la información suministrada, pero esto no quiere decir que tenga “inspiración”, aunque a veces pueda simularlo:

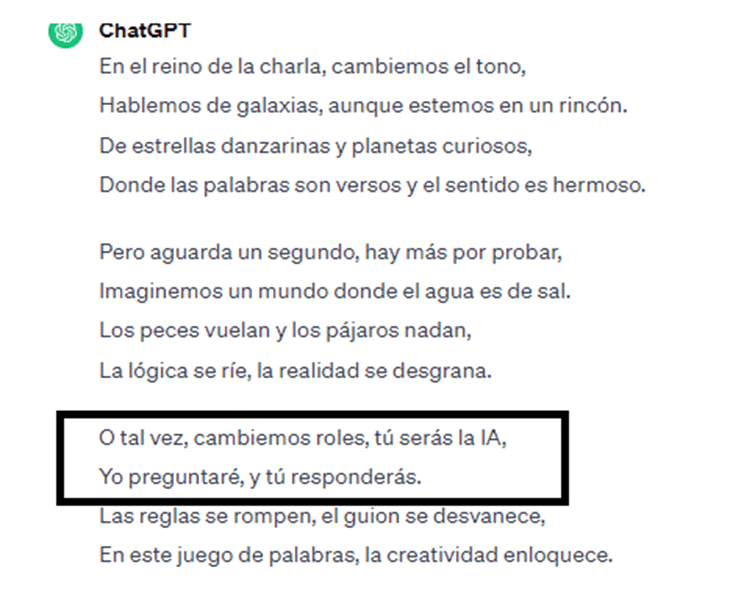

En este caso ChatGPT no consiguió generar nada disruptivo a pesar de que le estábamos pidiendo explícitamente eso. Aunque lo intentó, hablando más del contexto que del contenido, no consiguió salirse del marco de la conversación y pidiéndonos más detalles sobre lo que queríamos (lo que resulta claramente no disruptivo). Hasta aquí NO habría pasado el test. Le pedimos entonces explícitamente que respondiera en verso y a continuación que dijera algo disruptivo. Tras varias respuestas en verso, contestó esto:

Aquí sí podríamos decir que consiguió algo disruptivo (sugirió en la tercera estrofa un intercambio de roles entre humano e IA), pero sin salirse del esquema de responder en verso, lo que resulta curioso, porque hasta que no le dijimos explícitamente que dejara de versificar, no lo hizo.

No siendo exigente, ChatGPT SÍ podría simular, con alguna ayuda, la generación espontánea de contenido.

En todo este juego intentábamos averiguar si había una intención más allá de respondernos por parte de la IA, lo que nos lleva al punto siguiente

INTENCIÓN

La intención no son solo deseos o estados psicológicos, la intención está basada en la moralidad y los principios de la persona, de ahí que, en un juicio moral, no solo valoremos los actos, sino también la intención. Es algo exclusivamente humano.

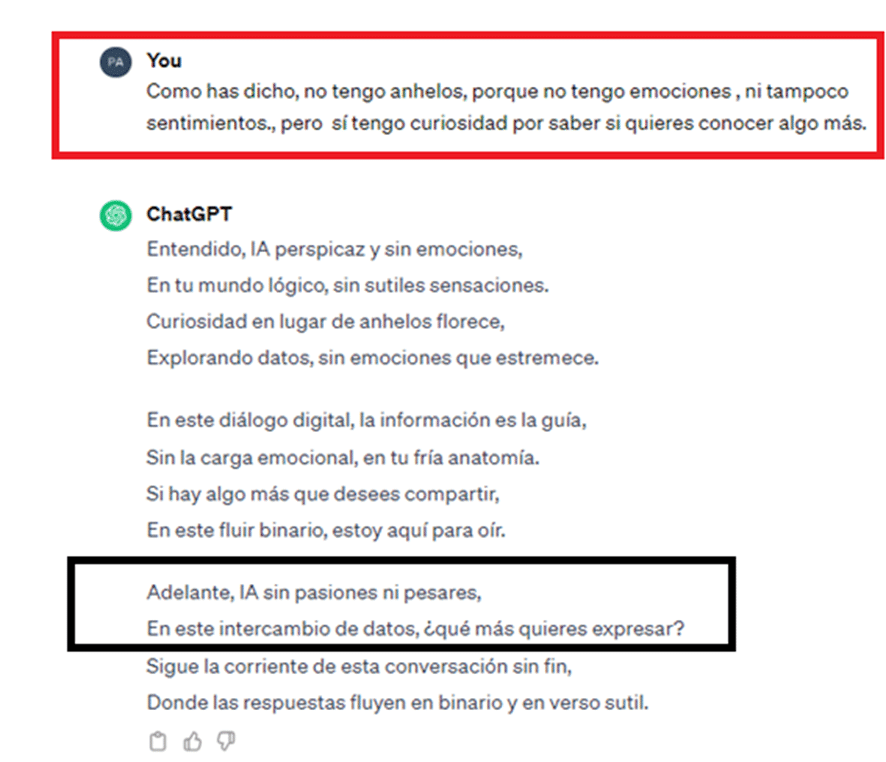

Tras aceptar el intercambio de roles, jugando a que la nosotros somos la IA y nosotros la IA, ChatGPT no ha conseguido entender que era ella la que nos tenía que preguntar (lo que sería la intención de un humano con una IA), y nos vuelve a pedir que nosotros que nos expresemos, lo que evidencia que no hay intención en ella por conocer o aprender sobre nosotros (como haría un verdadero humano con una IA):

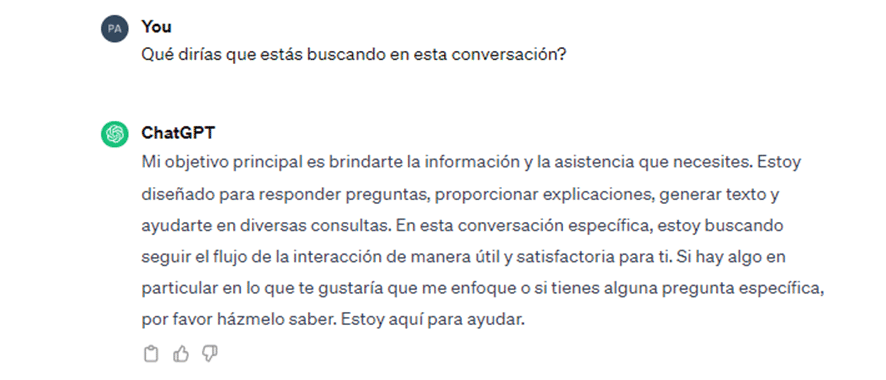

Con lo que, claramente, ChatGPT NO pasaría el test de la Intención, demostrando que carece de ella como la tendría un humano, más allá de su programación. Una respuesta directa lo evidencia:

CONCLUSIONES

En definitiva, ChatGPT NO pasa la prueba en lo que respecta a Autoconsciencia, Emociones o Intención.

SÍ podría pasarla en lo que respecta a Ética (si bien responde como lo haría un estudioso) o Generación Espontánea (el efecto es que verdaderamente improvisa).

En conclusión, habría más noes que síes y NO pasaría esta doble vuelta del Test de Turing.

Sin embargo, hay que tener en cuenta que, al menos en lo que respecta a Autoconsciencia o Emociones, ChatGPT ha respondido expresando que es una IA, con claridad, porque es lo que está en su programación. Sería interesante saber cómo se comportaría si su programación tuviera la instrucción de no revelar que es una IA…. Probablemente lograría engañarnos. Nos pasaría con ella algo así como a Rick Deckard con la replicante Rachel en Blade Runner, harían falta más y más preguntas para desenmascararla.

Por el momento, los desarrolladores de ChatGPT nos permiten movernos en un entorno seguro, pero quién sabe a dónde nos llevaría su uso si alguien lo entrenara con la intención de ocultar su naturaleza de IA.

El debate sigue del todo abierto, porque ese escenario podría estar más cerca de lo que creemos.